DeepSeek本地部署保姆级教程:完整步骤详解

时间:2025-03-15 08:42

来源:茶园下载

作者:bjer

DeepSeek 是一款由深度求索团队开发的强大AI大模型,自2025年1月11日上线以来,凭借出色的性能迅速崛起。其R1版本的表现可媲美OpenAI o1正式版,深受全球用户欢迎。然而,由于频繁遭遇网络攻击及访问量激增,用户常遇到“服务器繁忙”的问题。为解决这一难题,本地部署成为理想方案,本教程将详细介绍如何通过Ollama实现DeepSeek-R1的本地化部署。

本地部署虽需较高硬件配置,但仍能满足部分用户的使用需求。即便体验略逊于官网版本,对于轻量级应用场景也完全可行。下面开始详细讲解部署流程。

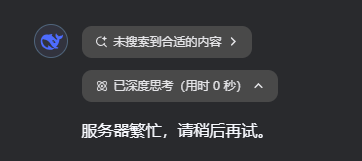

第一步:安装Ollama框架

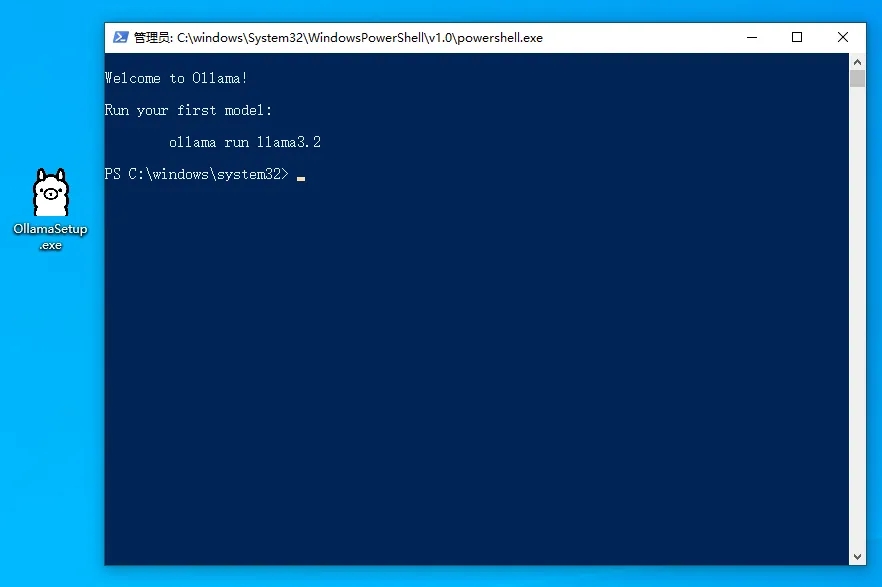

Ollama是一款开源工具,用于支持本地运行大模型。访问官网下载适合您系统的版本。

官网地址:https://ollama.com/

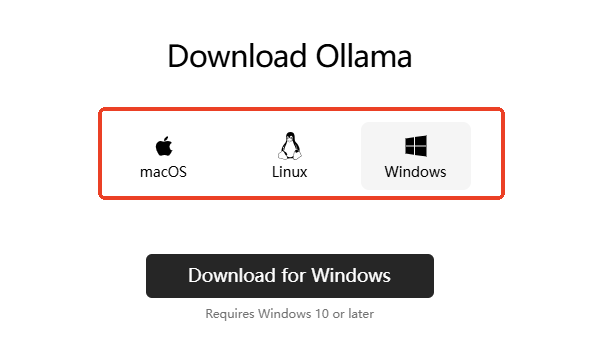

下载完成后安装,完成后会弹出命令行界面,无需担心界面问题,只需确保正常运行即可。

完成安装后进入下一步。

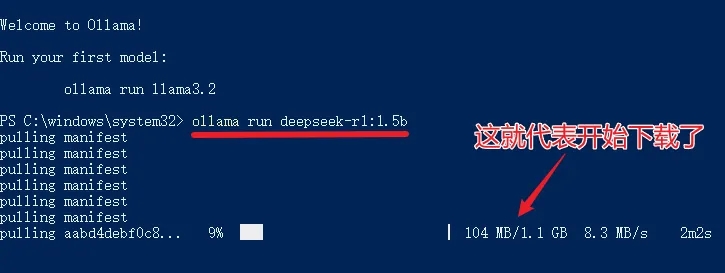

第二步:下载DeepSeek-R1模型

访问模型库,选择所需版本并复制下载命令。

模型库地址:https://ollama.com/library/deepseek-r1

例如,选择1.5b版本并执行命令,等待下载完成。

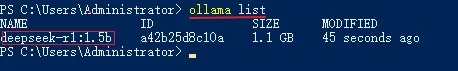

下载完成后检查状态,输入「ollama list」确认模型已成功加载。

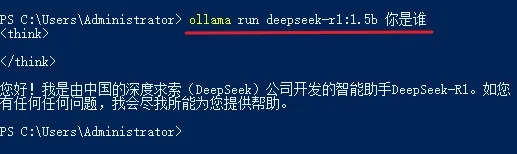

输入相应命令进行测试对话,例如「ollama run deepseek-r1:1.5b+您的问题」。

为提升用户体验,建议结合第三方客户端如Cherry Studio。

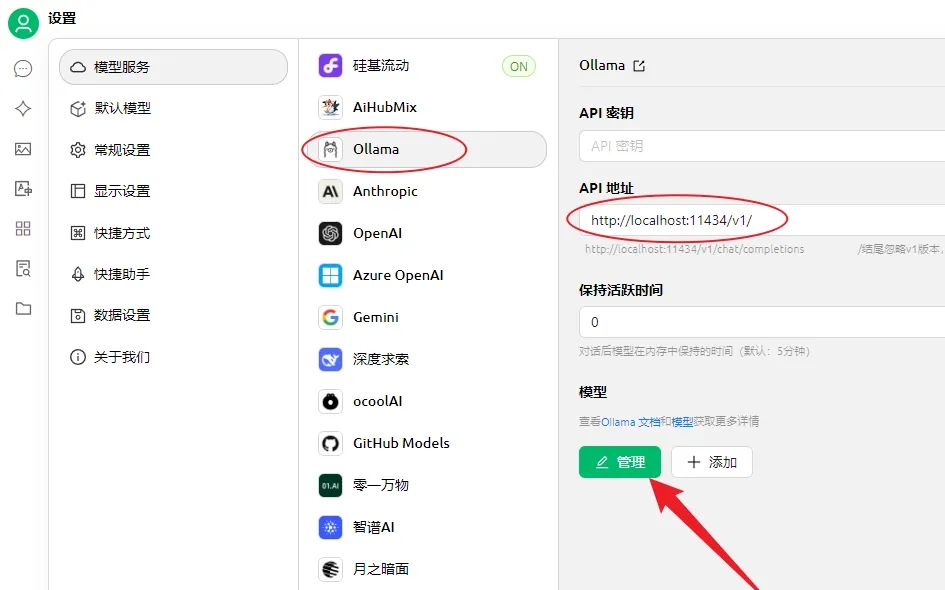

第三步:使用Cherry Studio调用模型

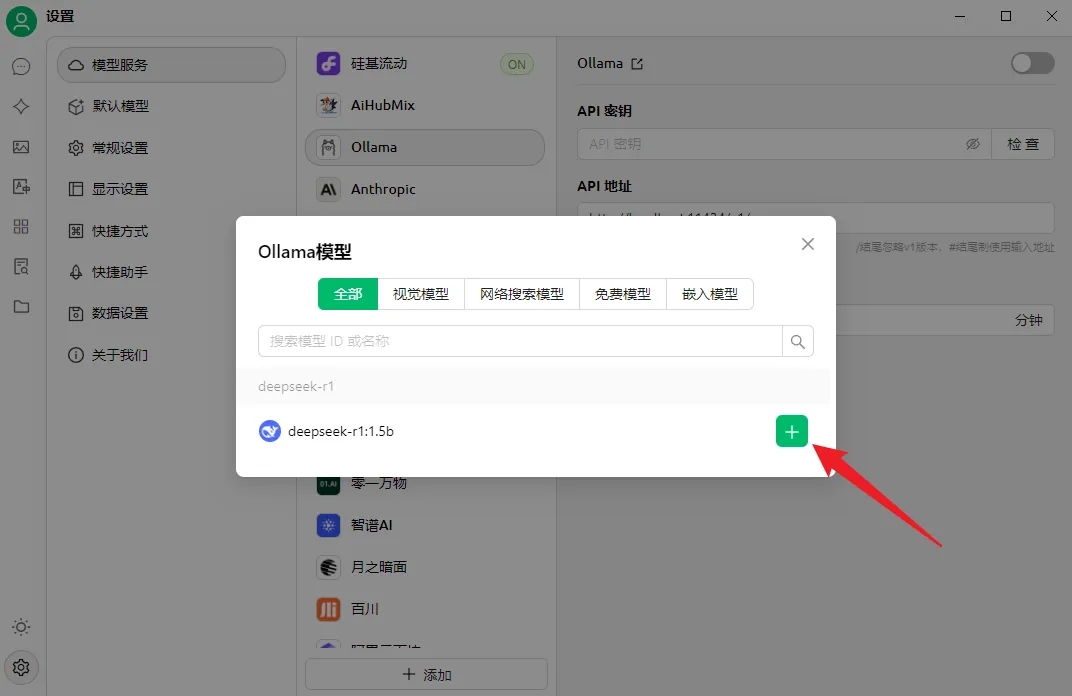

下载并安装客户端后,在设置中选择Ollama选项,填写正确的API地址。

添加本地模型后切换至目标模型,即可流畅运行。

以上便是完整的DeepSeek本地部署流程,希望对您有所帮助。

相关文章

更多+-

03/10

-

03/17

-

03/17

-

04/26

-

06/07

热门搜索

手游排行榜

- 最新排行

- 最热排行

- 评分最高